medienimport

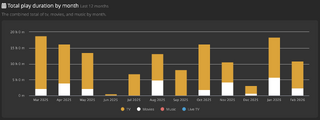

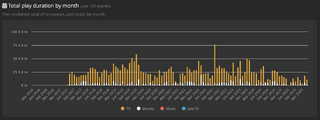

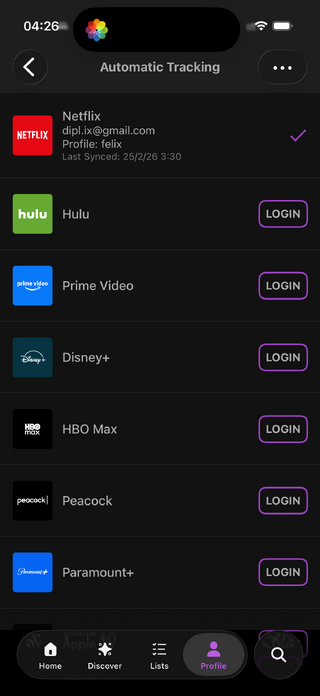

natürlich ist es eine schnapsidee, filme oder serien hier tracken zu wollen. wenn ich wollte, könnte ich das alles bei trakt machen. trakt arbeitet mit einem leicht obskuren dritt-dienst zusammen (younify.tv) um die historie des gesehenen von netflix auszulesen. tatsächlich kann man damit die historie aller grossen streaming-angebote abgreifen — wenn man younify.tv genug vertrauen entgegenbringt und (vollen) zugriff auf diese dienste gewährt. mein vertrauen hat vor ein paar jahren nur dafür gereicht, younify.tv zugriff auf mein netflix-konnto zu gewähren, weshalb ich jetzt einen teil meiner netflix-historie auch in trakt habe.

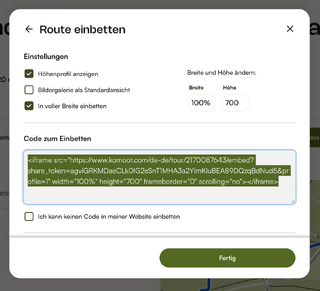

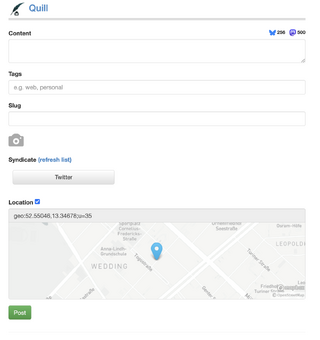

der vorteil ist, dass ich die von younify.tv abgegriffenen daten, jetzt auch wieder über die trakt-api selbst abgreifen kann, zum beispiel mit diesem script. mit ein zwei weiteren phyton scripten kann ich deshalb jetzt auch automatisch auf netflix gesehenes hier loggen.

schnapsidee hin oder her, sowohl trakt als auch ich wissen, dass die schnapsidee alles gesehene zu loggen, nur funktioniert, wenn es vorwiegend automatisch geht. wenn da nicht die vertrauensfrage wäre. ein datenleck bei trakt von 2014, das trakt erst 2019 offenlegte, zeigt, dass es nicht angebracht ist, trakt 100% vertrauen zu schenken. wenn ich mich recht erinnere hab ich die verbindung zwischen trakt und plex schon vor 2019 gekappt, weil mir das einen ticken zu unheimlich war, meine plex-historie ungefiltert in trakt zu leiten. bei netflix hielten sich meine bedenken in grenzen.

mit meinem selbstgebauten plex/tautulli-zu-kirby-exporter behalte ich die kontrolle und der import in die öffentliche liste klappt auch ohne drittanbieter ganz gut, fast vollautomatisch. ich muss nur noch eine wertung nachtragen.

und auch wenn ich bei der netflix → younify.tv → trakt.tv → wirres.net konstruktion weniger bis keine kontrolle habe, wollte ich diese automatisierungs-pipeline jetzt testen. dafür musste ich mir natürlich irgendeinen scheiss auf netflix ansehen.

also hab ich mir die erste folge being gordon ramsay angesehen. ich vermute das wird weder so erfolgreich wie netflix chefs table noch so ein hit wie drive to survive — auch wenn das strickmuster ähnlich ist. beim überfliegen der kritiken ist eine überschrift hängengeblieben, der ich direkt zustimmen möchte: gordon ramsay should not be so boring.

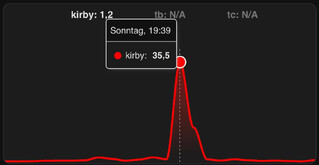

jedenfalls funktioniert der sync zwischen netflix, younify.tv, trakt.tv und wirres.net/kirby, wenn auch mit leichter verzögerung.

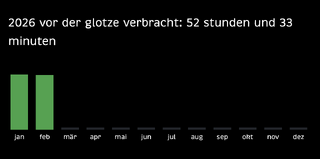

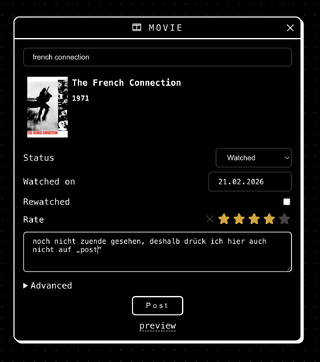

zum thema ex- und importe: ich habe auch ein script gefunden, mit dem sich die daten aus tautulli, also plex, mit letterboxd syncen lassen. damit habe ich jetzt lücken meiner film-timeline auf letterboxd geschlossen, auch wenn die timeline der filme die ich jemals sah auf letterboxd immer noch lücken in den letzten 10 jahren hat. schliesslich schau ich filme ja nicht nur auf plex, sondern auch auf amazon prime, im kino (gelegentlich) oder netflix. aber weils geht, weil ich daten jetzt aus plex und netflix rausbekomme, erscheint es mir logisch meine film-historie erstmal auf letterboxd zu vervollständigen. dann kann ich sie auch wieder hierher holen. aber bevor ich das mache sammel ich hier, bis auf ein paar ausnahmen — zu testzwecken — erstmal vornehmlich in 2026 gesehenes und gelesenes.

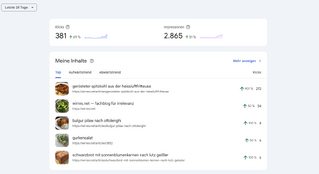

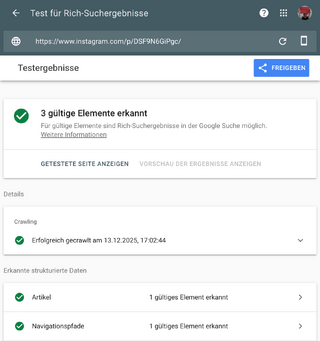

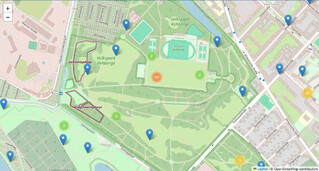

mit so einer „datenbank“ für gesehenenes und gelesenes setze ich mich übrigens auch geschickt selbst unter zugzwang. jetzt muss ich auch mal wieder ein buch lesen, damit ich es loggen kann. und damit schliesst sich der zirkel: ausgehen um drüber schreiben zu können, scheisse auf netflix schauen, ums zu prüfen ob es automatisch geloggt wird. morgens spazieren gehen um das wetter zu fotografieren und fotos und .gpx-tracks zu posten, kochen um rezepte maschinenlesbar zu veröffentlichen, schlafen, um zu sehen, wie gut der schlaftracker funktioniert. (b)loggen weil’s geht.